Функции одной переменной

1. Введение

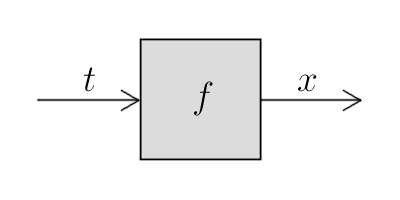

Функции — важнейшая деталь всего того внушительнейшего аппарата математической абстракции, который позволил современной высшей математике зайти так далеко. Представить себе математику без этого понятия трудно, если и вовсе возможно. Поэтому изложение в этой статье я постараюсь сделать по возможности плавным и последовательным, чтобы краеугольное понятие математического анализа не ускользнуло ни от одного читателя.На рубеже XVIII и XIX веков во Франции жил и усердно трудился знаменитый французский математик Пьер-Симон Лаплас. Среди прочего, он считал, что то существо, которое смогло бы узнать положение и скорость всех частиц во Вселенной в какой-то один момент времени, смогло бы на основании этой информации рассчитать всю историю вселенной от начала до скончания времён. Этим он утверждал, что будущее Вселенной полностью предопределено её текущим состоянием, пусть характер связей и будет бесконечно сложным.Мы не можем узнать состояние Вселенной с точностью до каждой частицы. Но предвидеть будущее, хотя бы в простейших вопросах, всё равно хотим. Мы хотим знать, куда поедет машина, которую мы построили, куда потечёт вода в выстроенном нами водопроводе, да вообще как будет работать любой сконструированный нами механизм. Хотя бы примерно. Хотя бы в большинстве случаев.Здесь-то и приходит столь необходимое понятие абстракции. Мы абстрагируемся от бесконечной Вселенной, бесконечно сложно взаимодействующей с нашей шестерёнкой. Мы предполагаем, что притяжение удалённых на миллионы световых лет звёзд не сильно повлияет на воду в нашем водопроводе. Мы надеемся, что наша машина не перевернётся от подвернувшейся на дороге пылинки.Далее. Итак, мы хотим узнать положениеЗнаем мы, что в чёрном ящике, или нет, но всегда, когда мы говорим «функция», мы подразумеваем чёрный ящик целиком, не вдаваясь в подробности его работы.Зависимости бывают разными. Это могут быть зависимости положения от времени, объёма от температуры и так далее. Положение может измеряться в метрах, время — в секундах, температура — в градусах, допустим, по шкале Кельвина. Физики любят везде явно указывать единицы измерения, но мы будем их опускать, потому что единицы измерения нас не так волнуют и не сильно влияют на решение (ну в самом деле, от того, назовём мы метр метром или ста сантиметрами, решение задачи не изменится). Пусть, например, мы рассматриваем элементарную зависимость площади квадрата от длины его стороны:

Оно может также обозначаться как

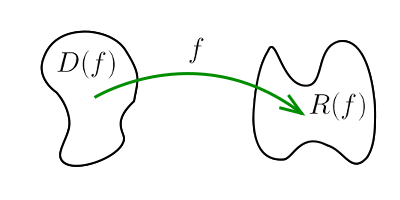

Говорят, что функция

- Её областью определения является множество положительных вещественных

чисел. Оно обозначется как

или

.

- Её областью значений также является множество положительных

вещественных чисел. Этот факт, правда, неплохо было бы доказать, ведь раз

мы условились, что функция — это «чёрный ящик», то если мы и можем

точно знать, что ей можно пускать на вход, то что получится на выходе, да

ещё и во всех возможных ситуациях — угадать не так-то просто.К счастью, в нашем случае всё тривиально. Достаточно заметить, что,

во-первых, наша функция никогда не выдаёт отрицательные

числа (и нуль), а во-вторых, что для любого заданного положительного числа

можно найти соответствующее положительное

такое, что

. Ну, здесь достаточно взять

.

Со школьной скамьи все должны иметь представление о такой функции, как

синус. В школе мы учили, что синус — это отношение

противолежащего катета к гипотенузе, и что это есть некоторая функция угла.

Поэтому логично заключить, что областью определения синуса является

множество  возможных углов в прямоугольном

треугольнике. И, соответственно, областью значений синуса тогда является

множество

возможных углов в прямоугольном

треугольнике. И, соответственно, областью значений синуса тогда является

множество  всевозможных соотношений катета и гипотенузы. Это

несложно проверить. Ясно, что мы можем бесконечно «сплющивать»

треугольник, чтобы отношение одного из катетов к гипотенузе стало сколь

угодно близким к нулю, а другого — к единице. При этом сам ноль и единицу

мы получить никогда не сможем.

Двигайте точку A, чтобы закрасить область определения и область значений

функции

всевозможных соотношений катета и гипотенузы. Это

несложно проверить. Ясно, что мы можем бесконечно «сплющивать»

треугольник, чтобы отношение одного из катетов к гипотенузе стало сколь

угодно близким к нулю, а другого — к единице. При этом сам ноль и единицу

мы получить никогда не сможем.

Двигайте точку A, чтобы закрасить область определения и область значений

функции  .

.

2. Непрерывность

Перейдём теперь к ещё одному безумно важному понятию высшей математики — непрерывности функции.Физические процессы всегда (ну почти всегда) протекают непрерывно. Вода не может закипеть мгновенно. Сколь угодно быстро — возможно. Но не мгновенно. Она всегда пройдёт все промежуточные температуры от комнатной догде

А это уже можно изобразить: То есть геометрически это условие можно интерпретировать так: если взять произвольную точку на графике функции и нарисовать вокруг неё прямоугольник размерапри

Отдельным классом непрерывных функций являются так называемые липшицевы функции, важные в

теории дифференциальных уравнений. Функция называется липшицевой в

точке  , если существует некоторая достаточно большая

положительная константа

, если существует некоторая достаточно большая

положительная константа  такая, что

такая, что

из области определения

из области определения  . Если одна и та же константа

. Если одна и та же константа  подходит для всех точек

подходит для всех точек  из области определения

из области определения  , то

, то  называется

просто липшицевой.Геометрически это выглядит так: нужно подобрать константу

называется

просто липшицевой.Геометрически это выглядит так: нужно подобрать константу  такую, чтобы

весь (да-да, совсем весь) график функции умещался в подсвеченной на рисунке

области-«бабочке» независимо от выбора её центральной точки

такую, чтобы

весь (да-да, совсем весь) график функции умещался в подсвеченной на рисунке

области-«бабочке» независимо от выбора её центральной точки  :

Видно, что при

:

Видно, что при  для этой функции всё плохо (график где-нибудь да

выползает за рамки подсвеченной области), а при

для этой функции всё плохо (график где-нибудь да

выползает за рамки подсвеченной области), а при  — хорошо.

Значит, изображённая функция липшицева с константой Липшица, равной 1. (Из

рисунка ясно, что если условие выполнилось для какого-то одного

— хорошо.

Значит, изображённая функция липшицева с константой Липшица, равной 1. (Из

рисунка ясно, что если условие выполнилось для какого-то одного  , то оно

выполнится и для всех бо́льших

, то оно

выполнится и для всех бо́льших  . Так вот, константа Липшица

функции

. Так вот, константа Липшица

функции  — это наименьшее

— это наименьшее  , при котором для неё выполняется

условие липшицевости во всех точках.)Для полноты картины приведём пример непрерывной функции, не являющейся

липшицевой. Это функция

, при котором для неё выполняется

условие липшицевости во всех точках.)Для полноты картины приведём пример непрерывной функции, не являющейся

липшицевой. Это функция  :

Здесь, на самом деле, все точки «хорошие» — кроме нуля. Если долго

увеличивать график, то можно увидеть, что при

:

Здесь, на самом деле, все точки «хорошие» — кроме нуля. Если долго

увеличивать график, то можно увидеть, что при  даже при

даже при  график корня выходит за допустимые границы. Дело тут в том, что в нуле

корень возрастает практически вертикально — угол между двумя

симметричными ветвями на этом графике равен

график корня выходит за допустимые границы. Дело тут в том, что в нуле

корень возрастает практически вертикально — угол между двумя

симметричными ветвями на этом графике равен  . Мы ещё вернёмся к

этому примеру и изучим подробно этот факт, когда будем изучать производные.

. Мы ещё вернёмся к

этому примеру и изучим подробно этот факт, когда будем изучать производные.

Наконец, функция называется непрерывной, если она непрерывна в каждой точке своей

области определения для всех

В начале этого параграфа мы говорили о том, что непрерывность нужна нам как

способ сужать круг поисков при решении физических задач, способ отсекать

заведомо ложные решения. Давайте проверим это на простом примере из

механики.Опять-таки, со школы мы знаем закон равноускоренного движения материальной

точки. Если в момент времени  неподвижная точка начинает двигаться по

прямой с ускорением

неподвижная точка начинает двигаться по

прямой с ускорением  (знак которого определяет направление движения), то

её положение в произвольный последующий момент времени

(знак которого определяет направление движения), то

её положение в произвольный последующий момент времени  описывается

формулой

описывается

формулой

:

Но можем ли мы доказать факт непрерывности математически,

используя определение, что подарил нам Огюстен Луи? Давайте попробуем.Зафиксируем произвольное ускорение

:

Но можем ли мы доказать факт непрерывности математически,

используя определение, что подарил нам Огюстен Луи? Давайте попробуем.Зафиксируем произвольное ускорение  . Это значит, что наше дальнейшее

доказательство годится для любого

. Это значит, что наше дальнейшее

доказательство годится для любого  , но на протяжении доказательства

, но на протяжении доказательства  не изменяется (фиксировано!). Зафиксируем также произвольную точку

не изменяется (фиксировано!). Зафиксируем также произвольную точку  . Наша задача теперь — для любого сколь угодно маленького

положительного

. Наша задача теперь — для любого сколь угодно маленького

положительного  подобрать

подобрать  такое, чтобы при

такое, чтобы при

выполнялось

выполнялось

и так проще простого, поэтому давайте подробнее

распишем второе, в котором есть

и так проще простого, поэтому давайте подробнее

распишем второе, в котором есть  .

Но нам-то нужно меньше

.

Но нам-то нужно меньше  ! Ну, что ж, на самом деле мы

подобрались к ответу довольно близко: если мы теперь научимся выбирать

! Ну, что ж, на самом деле мы

подобрались к ответу довольно близко: если мы теперь научимся выбирать

таким, что

наша цель окажется достигнутой!Ну а подобрать такое

таким, что

наша цель окажется достигнутой!Ну а подобрать такое  уже достаточно просто. Смотрите. Пусть

уже достаточно просто. Смотрите. Пусть

всегда будет меньше единицы. (Скорее всего, так и будет. Мы же

рассматриваем всё для маленьких

всегда будет меньше единицы. (Скорее всего, так и будет. Мы же

рассматриваем всё для маленьких  и

и  .) Тогда наше

выражение (2.1) упрощается:

.) Тогда наше

выражение (2.1) упрощается:

так, чтобы вместо непонятного

(2.2) выполнялось

так, чтобы вместо непонятного

(2.2) выполнялось

и

и  у нас

фиксированные и не зависят от

у нас

фиксированные и не зависят от  , уже простейшим образом

разрешается: достаточно взять

, уже простейшим образом

разрешается: достаточно взять  такое, что

такое, что

по-честному

всегда не больше единицы, как мы предполагали ранее.Ура!Итак, мы получили искомую функцию

по-честному

всегда не больше единицы, как мы предполагали ранее.Ура!Итак, мы получили искомую функцию  , которая

обеспечивает выполнение определения непрерывности в данной точке

, которая

обеспечивает выполнение определения непрерывности в данной точке  . Тут

стоит обратить внимание на то, что само

. Тут

стоит обратить внимание на то, что само  очень даже фигурирует в

формуле этой функции в качестве постоянного параметра.Что ж, кажется, мы убедились, что наше определение более-менее адекватно

отражает суровую реальность. Функция непрерывна — значит, можно подобрать

очень даже фигурирует в

формуле этой функции в качестве постоянного параметра.Что ж, кажется, мы убедились, что наше определение более-менее адекватно

отражает суровую реальность. Функция непрерывна — значит, можно подобрать

. Непрерывна — нельзя (смотри пример в начале параграфа).

Правда, подобрать

. Непрерывна — нельзя (смотри пример в начале параграфа).

Правда, подобрать  оказалось несколько сложновато.

Что же мы будем делать, если вместо скромной

оказалось несколько сложновато.

Что же мы будем делать, если вместо скромной  у нас будет функция

посложнее? Что ж, тут-то и всплывёт главное достоинство строго математического

определения — мы сможем доказать непрерывность многих функций,

даже не обращаясь к их конкретному виду. Например, вместо того, чтобы

ковыряться в

у нас будет функция

посложнее? Что ж, тут-то и всплывёт главное достоинство строго математического

определения — мы сможем доказать непрерывность многих функций,

даже не обращаясь к их конкретному виду. Например, вместо того, чтобы

ковыряться в  -

- -терминологии с функцией вроде

-терминологии с функцией вроде

Если нарисовать график этой функции, то не возникает никаких сомнений в её непрерывности при любых значениях параметра

Выражение

(Все ведь помнят формулу разности квадратов, верно?)Итак, что же мы имеем? У нас уже есть свойство

Что же касается суммы, то её можно расписать так:

В первом равенстве мы просто добавили и вычли под модулем одно и то же число. (Убедитесь, что вы понимаете следующее за ним неравенство, это стандартное неравенство для модуля суммы.)Итого исходное соотношение расписывается в виде

(2.1)

(2.2)

и теперь достаточно подобрать

А это неравенство при учёте того обстоятельства, что

Например, просто взять в два раза меньше, сократив двойку:

Ну а для пущей строгости нашего доказательства возьмём

Мы берём этот минимум, чтобы удостовериться, что

мы сможем просто сказать, что это сумма произведений непрерывных функций, а значит, автоматически непрерывная функция.

2.1. Арифметика непрерывных функций

Понятно, что на функциях вещественной переменной можно ввести естественную арифметику: если есть две функцииЭто позволяет избавиться от всех проблем с делением на ноль. «А? Что? Вы говорите, в этой точке деление на ноль? Да вы что, эта точка вне области определения, мы её даже не рассматриваем.»Дальше естественный вопрос, особенно в контексте произнесённых пафосных речей про важность строгих математических определений: что будет, если нам известно, что функции

Раз уж мы хотим доказать непрерывность

(2.1.3)

Неравенство для модуля суммы подсказывает нам, что![\begin{array}{rlcll}

\big|&\hspace{−0.75em} \big(f(x)+g(x)\big) &−& \big(f(x_0)+g(x_0)\big) &\hspace{−0.75em}\big| = \\[2mm]

=\big|&\hspace{−0.375em} f(x)+g(x) &−& \hspace{0.375em}f(x_0)−g(x_0)&\hspace{−0.75em}\big| \\[2mm]

=\big|&\hspace{−0.75em} \big(f(x)−f(x_0)\big) &+& \big(g(x)−g(x_0)\big) &\hspace{−0.75em}\big|